기존 pix2pix의 한계

Pix2pix는 이미지 변환 작업에서 paired data가 필요합니다. 그러나 실제 세계에서는 paired data {x_i, y_i}를 구하기 어렵거나 비용이 많이 들 수 있습니다.

본 논문에서 제안하는 모델인 CycleGAN은 이러한 한계를 해결하기 위해 unpaired data를 사용합니다. 이를 통해 paired data가 없어도 이미지 변환 작업을 수행할 수 있습니다.

Unpaired Data 사용 시 문제점

- 대응되는 데이터 부재: 생성자의 input image와 target image 간의 대응 관계를 학습하기 어려움.

- Mode Collapse: 생성자가 다양성이 부족한 몇 가지 유형의 이미지만을 생성하는 현상이 심해짐.

- 구조적 일관성 부족: 생성된 이미지가 원본 이미지의 구조적인 일관성을 유지하기 어려움.

Cycle Consistency

CycleGAN은 다음과 같은 방식으로 작동합니다:

- G: X -> Y 매핑과 F: Y -> X 매핑을 adversarial loss로 학습.

- Cycle Consistency Loss: F(G(x))≈x, 를 만족하도록 학습.

- G(x)=y′는 x와 pair가 되는 에 근사.

- F(y)=x′는 y와 pair가 되는 x에 근사.

Loss Function

CycleGANs의 Loss Function은 Adversarial Loss와 Cycle Consistency Loss로 구성됩니다.

Adversarial Loss:

(1) X -> Y 매핑

(2) Y -> X 매핑

Cycle Consistency Loss:

Full Loss Function:

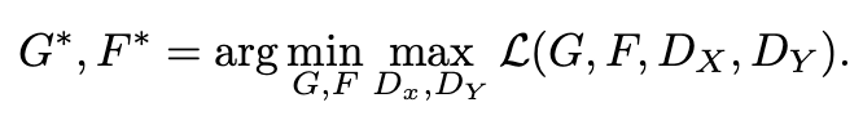

결국, Loss를 최소화하는 G,F와 Loss를 최대화하는 Dx, Dy를 찾는 문제가 됩니다.

Experiments

Label -> Photo: CycleGAN이 paired data로 학습된 pix2pix와 가장 유사한 성능을 보입니다.

Photo -> Map: CycleGAN이 paired data로 학습된 pix2pix와 가장 유사한 성능을 보입니다.

Style Transfer

- Photo -> Artistic Style

- Apple <-> Orange: CycleGAN은 X -> Y, Y -> X 매핑 모두를 학습하여 아래와 같은 Style transfer가 가능합니다.

Conclusion

CycleGAN은 image-to-image translation 문제에 대한 새로운 접근법을 제시합니다. paired data 없이도 학습이 가능하며, 두 도메인 간의 image style transfer를 가능하게 합니다. Cycle Consistency Loss의 도입으로 한 도메인에서 다른 도메인으로 변환한 후 다시 원래 도메인으로 변환할 수 있게 하여, 도메인 간에 일관적인 특징을 유지하면서 각 도메인의 고유한 스타일을 학습할 수 있습니다.

한계점:

- 입력 데이터의 구조 변환이 어렵습니다.

- 원하지 않는 부분에도 스타일이 변경될 수 있습니다.